Ο πολύ γνωστός στο ευρύ κοινό από την περίοδο της πανδημίας, γιατρός Νίκος Καπραβέλος, διευθυντής ΜΕΘ στο Νοσοκομείο «Παπανικολάου» της Θεσσαλονίκης, κρατάει εμφανώς οργισμένος, αλλά και απηυδισμένος, το κινητό τηλέφωνό του δείχνοντάς μας μία από τις πολλές διαδικτυακές απάτες με χρήση AI της οποίας έπεσε θύμα.

Ολα ξεκίνησαν πριν από έναν χρόνο, όταν φίλοι, γνωστοί και συγγενείς του τον ειδοποίησαν πως τον είδαν, σε αναρτήσεις στα μέσα κοινωνικής δικτύωσης, να διαφημίζει τη «θαυματουργή» δράση σκευασμάτων με τα οποία μπορεί κάποιος να καθαρίσει «στο σπίτι» τα αιμοφόρα αγγεία του, προλαμβάνοντας ένα εγκεφαλικό επεισόδιο.

«Ο αδελφός μου δεν μπορούσε να το πιστέψει ότι δεν είμαι εγώ. Η εικόνα και η φωνή ήταν ακριβώς ίδια με τη δική μου. Ελάχιστοι οικείοι μου κατάλαβαν τη διαφορά».

«Ο αδελφός μου δεν μπορούσε να το πιστέψει ότι δεν είμαι εγώ. Η εικόνα και η φωνή ήταν ακριβώς ίδια με τη δική μου. Ελάχιστοι οικείοι μου κατάλαβαν τη διαφορά» λέει ο ίδιος, αδυνατώντας να αποδεχτεί τη στοχοποίησή του, όπως λέει, στη συγκεκριμένη απάτη.

Αν και έχει περάσει ένας χρόνος από την αρχική καταγγελία στη Δίωξη Ηλεκτρονικού Εγκλήματος στη Θεσσαλονίκη, λέει στην «Κ» ότι συνεχίζουν να έρχονται στο νοσοκομείο όπου εργάζεται γράμματα απλών πολιτών που τον ευχαριστούν για το φάρμακο που τους πρότεινε, ενώ στο κινητό του δέχεται ακόμη και σήμερα ερωτήσεις από φίλους και γνωστούς για το εάν διαφημίζει σκευάσματα που προλαμβάνουν τα εγκεφαλικά επεισόδια.

Τα προϊόντα που διαφημίζει, εν αγνοία του, ο κ. Καπραβέλος είναι συμπληρώματα διατροφής με διάφορες ονομασίες, για τα οποία ο ΕΟΦ έχει προειδοποιήσει πως διαφημίζονται ως φαρμακευτικά προϊόντα χωρίς να έχουν σχετική άδεια και ενδέχεται να θέσουν σε κίνδυνο την υγεία όσων τα καταναλώνουν. Θύμα πανομοιότυπης απάτης έχει πέσει και ο καθηγητής του Πανεπιστημίου Θεσσαλίας, Κωνσταντίνος Γουργουλιάνης.

Οι απάτες ξεκινούν από αναλώσιμους διαδικτυακούς τόπους στο εξωτερικό (στις περιπτώσεις των κ. Καπραβέλου και Γουργουλιάνη σε Ολλανδία και Ισλανδία, αντίστοιχα), οι οποίοι στη συνέχεια καταργούνται γρήγορα, αφού όμως έχουν αξιοποιήσει αδρανείς ή ψεύτικους λογαριασμούς στα μέσα κοινωνικής δικτύωσης για να διαδώσουν τα μηνύματα.

Η πιο γνωστή, βέβαια, στο ευρύ κοινό -και σχετικά ανώδυνη- απάτη deepfake είναι η ψεύτικη εικόνα του Πάπα Φραγκίσκου, τον περασμένο Μάρτιο, με ένα επώνυμο λευκό μπουφάν. Η φωτογραφία δημιουργήθηκε μέσω τεχνητής νοημοσύνης και συγκεκριμένα με το Midjourney ΑΙ. Η εικόνα έγινε viral, λαμβάνοντας πάνω από είκοσι εκατομμύρια προβολές. Ο συγγραφέας Ράιν Μπρόντερικ τη χαρακτήρισε ως «την πρώτη πραγματική υπόθεση παραπληροφόρησης τεχνητής νοημοσύνης σε μαζικό επίπεδο».

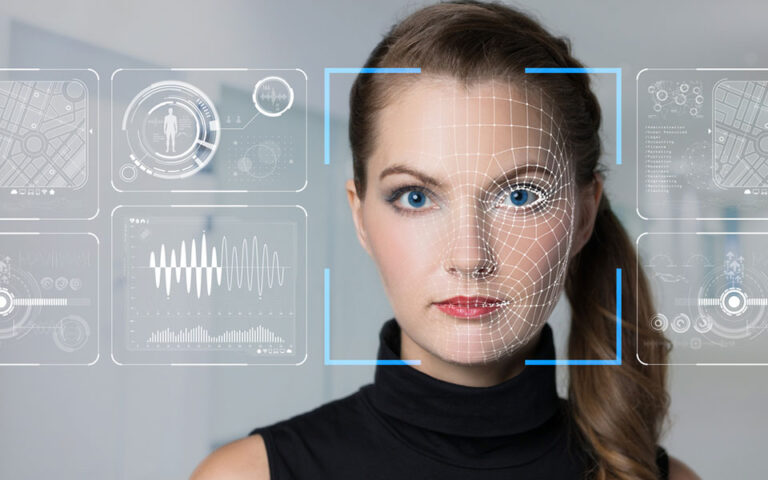

Τι είναι τα deepfakes

Τα deepfakes είναι συνθετικά μέσα που έχουν υποστεί ψηφιακή επεξεργασία για να αντικαταστήσουν πειστικά την ομοιότητα ενός ατόμου με αυτήν ενός άλλου. Αν και η δημιουργία ψεύτικου περιεχομένου δεν είναι νέα, τα deepfakes αξιοποιούν ισχυρές τεχνικές από τη μηχανική μάθησης και την τεχνητή νοημοσύνη για να δημιουργήσουν οπτικό και ηχητικό περιεχόμενο που μπορεί πιο εύκολα να εξαπατήσει.

Τα deepfakes είναι συνθετικά μέσα που έχουν υποστεί ψηφιακή επεξεργασία για να αντικαταστήσουν πειστικά την ομοιότητα ενός ατόμου με αυτήν ενός άλλου.

«Για να δημιουργηθούν, δεν χρειάζονται μεγάλο τεχνολογικό υπόβαθρο και γνώσεις» εξηγεί στην «Κ» ο Αλέξανδρος Βασιλαράς, επικεφαλής του Τμήματος Εξέτασης Ψηφιακών Πειστηρίων στη Διεύθυνση Εγκληματολογικών Ερευνών, σπεύδοντας όμως να προσθέσει: «Χρειάζεται βεβαίως μια εξοικείωση με τα συγκεκριμένα τεχνολογικά εργαλεία. Αν κάποιος ασχοληθεί με αυτά και βρει επίσης ένα πρόσωπο για το οποίο υπάρχουν πολλά δεδομένα, τότε θα καταφέρει να δημιουργήσει ένα deepfake video. Οσο πιο πολλές οι φωτογραφίες και τα βίντεο ενός ανθρώπου που υπάρχουν στο Διαδίκτυο τόσο πιο εύκολα θα εκπαιδευτεί το μοντέλο της απάτης μέσω ΑΙ. Απαιτούνται επίσης αρκετά δεδομένα εικόνων, ήχων και βίντεο (data sets) για να παραχθούν αληθοφανή deepfakes. Γι’ αυτούς του λόγους, συνήθως, προς το παρόν τουλάχιστον, θύματα των deepfake videos είναι διάσημοι και πρόσωπα με αναγνωρισιμότητα».

Οσο πιο πολλές οι φωτογραφίες και τα βίντεο ενός ανθρώπου που υπάρχουν στο Διαδίκτυο τόσο πιο εύκολα θα εκπαιδευτεί το μοντέλο της απάτης μέσω ΑΙ.

Πού χρησιμοποιούνται;

Λόγω της ενδυνάμωσης της τεχνολογίας και της εύκολης πρόσβασης όλων σε αυτή, η τεχνολογία deepfake έχει εξελιχθεί και γίνεται ολοένα και πιο πειστική, ενώ η χρήση της δεν περιορίζεται στην παραδοσιακή ψυχαγωγία και τα βιντεοπαιχνίδια. Τα deepfakes έχουν συγκεντρώσει αυτή τη στιγμή την ευρεία προσοχή των Αρχών και των εξεταστών ψηφιακών πειστηρίων για πιθανή χρήση τους στη δημιουργία υλικού σεξουαλικής κακοποίησης παιδιών, πορνογραφικών βίντεο διασημοτήτων, πορνό εκδίκησης (revenge porn), ψεύτικες ειδήσεις, φάρσες, εκφοβισμό, αλλά και οικονομικές απάτες.

Ανησυχητικά δείγματα

Ενα από τα πιο ανησυχητικά περιστατικά κακόβουλης χρήσης των deepfakes συνέβη τον περασμένο Σεπτέμβριο στην περιοχή Αλμεντραλέχο στην Ισπανία. Μαθητές χρησιμοποίησαν μια εύκολα προσβάσιμη εφαρμογή, την Clothoff, για να δημιουργήσουν ρεαλιστικές γυμνές εικόνες των συμμαθητών τους. Για μόλις 10 ευρώ, έλαβαν εικόνες που δημιουργήθηκαν από Τεχνητή Νοημοσύνη, οι οποίες στη συνέχεια κυκλοφόρησαν, παραβιάζοντας το απόρρητο και την αξιοπρέπεια ανήλικων παιδιών. «Αυτή η περίπτωση, όχι μόνο υπογραμμίζει την ευκολία με την οποία μπορεί να γίνει κατάχρηση των τεχνολογιών AI, αλλά προβάλλει επίσης την επείγουσα ανάγκη για ισχυρό νομικό και ηθικό πλαίσιο που θα διέπει τη χρήση της», σημειώνει ο κ. Βασιλαράς.

Mαθητές στην Ισπανία χρησιμοποίησαν μια εύκολα προσβάσιμη εφαρμογή, την Clothoff, για να δημιουργήσουν ρεαλιστικές γυμνές εικόνες των συμμαθητών τους.

Παρότι οι deepfakes απάτες είναι πιο συχνές στο εξωτερικό, πρόσφατες υποθέσεις αναδεικνύουν την άνοδο του φαινομένου και στη χώρα μας. Εκτός από την υπόθεση του Νίκου Καπραβέλου, υπάρχει και το πρόσφατο παράδειγμα της δημοσιογράφου Βίκυς Χαντζή. Η εικόνα και η φωνή της αποτέλεσαν αντικείμενο επεξεργασίας με Τεχνητή Νοημοσύνη για τις ανάγκες προώθησης διαδικτυακού καζίνου, γεγονός που, σύμφωνα με τον κ. Βασιλαρά, υπογραμμίζει μια ανησυχητική τάση στην Ελλάδα, η οποία απαιτεί ετοιμότητα.

«Κακόβουλοι χρήστες μπορούν να παραπλανήσουν το σύστημα αναγνώρισης προσώπου και να προσποιηθούν τον κάτοχο ενός λογαριασμού σε πλατφόρμες κοινωνικής δικτύωσης».

Ο Αλ. Βασιλαράς υπογραμμίζει πως «δεν είναι πια λίγες οι φορές όπου κακόβουλοι χρήστες χρησιμοποιούν τη δυνατότητα των deepfakes προκειμένου να παραβιάσουν την ασφάλεια της διπλής αυθεντικοποίησης (2FA) που απαιτείται για την πρόσβαση σε προσωπικούς λογαριασμούς σε γνωστές πλατφόρμες κοινωνικής δικτύωσης, καθώς μπορούν να παραπλανήσουν, για παράδειγμα το σύστημα αναγνώρισης προσώπου και να προσποιηθούν τον κάτοχο του λογαριασμού».

Επίσης εξηγεί ποια θα είναι τα επόμενα στάδια στα οποία θα φτάσουν σύντομα οι απάτες μέσω ΑΙ και deepfake videos. «Είναι δεδομένο ότι σύντομα οι κλασικές τηλεφωνικές απάτες με συγγενικό πρόσωπο που έχει εμπλακεί σε πρόκληση τροχαίου ατυχήματος θα αλλάξουν μορφή. Θα αρχίσουμε, δηλαδή, να ακούμε αγαπημένα μας πρόσωπα σε ηχητικά αρχεία, ή θα μας έρχονται βίντεο όπου θα μας ζητούν άμεσα οικονομική βοήθεια. Η απάτη θα έχει ακόμα πιο ρεαλιστικά στοιχεία. Θα γίνει εφικτό ακόμα και να πραγματοποιείται live κλήση μέσω των γνωστών πλατφορμών κοινωνικής δικτύωσης».

«Θα αρχίσουμε να ακούμε αγαπημένα μας πρόσωπα σε ηχητικά αρχεία ή θα μας έρχονται βίντεο όπου θα μας ζητούν άμεσα οικονομική βοήθεια. Η απάτη θα έχει ακόμα πιο ρεαλιστικά στοιχεία».

Aν συνυπολογίσουμε, όπως σημειώνει ο εξεταστής ψηφιακών πειστηρίων, πως ο μέσος χρήστης του Διαδικτύου δέχεται πάρα πολύ μεγάλο όγκο πληροφοριών σε καθημερινή βάση, καταλαβαίνουμε ότι δεν είναι εύκολο για τον καθένα να «ξεψαχνίζει» τυχόν λάθη σε αυτά που βλέπει ή ακούει.

Ο ρόλος της εγκληματολογικής έρευνας

Στην αντιμετώπιση αυτών των αναδυόμενων ψηφιακών προκλήσεων, ο ρόλος της Διεύθυνσης Εγκληματολογικών Ερευνών γίνεται όλο και πιο σημαντικός. Ο κ. Βασιλαράς σημειώνει πως οι γνωστές πλατφόρμες κοινωνικής δικτύωσης, όπως το TikTok, το Meta και το YouTube, έχουν αυστηροποιήσει το πλαίσιο για την προστασία των χρηστών από επιβλαβές περιεχόμενο, ενώ οι αρχές επιβολής του νόμου -και στη χώρα μας- εκπαιδεύονται συνεχώς στο πώς να αναγνωρίζουν περιεχόμενο deepfakes.

Σε κάθε περίπτωση, η διασταύρωση της Τεχνητής Νοημοσύνης, της ψηφιακής εγκληματολογίας και των προκλήσεων που θέτουν τα deepfakes, ιδιαίτερα στο πλαίσιο της εκδικητικής πορνογραφίας και της απάτης, απαιτεί μια πολυδιάστατη προσέγγιση. Σύμφωνα με τον Αλ. Βασιλαρά, αυτή περιλαμβάνει την τεχνολογική καινοτομία, την εξέταση των ηθικών ζητημάτων, τη νομική ρύθμιση, αλλά και την ευαισθητοποίηση του κοινού.

«Πρέπει πια να εκπαιδεύσουμε μοντέλα που θα “κυνηγούν” αυτά τα έξυπνα μοντέλα. H ΑΙ θα κυνηγάει την AI».

«Τα Εγκληματολογικά Εργαστήρια της ΕΛ.ΑΣ., εξοπλισμένα με εργαλεία αιχμής και τεχνογνωσία, αποτελούν βασικό παράγοντα για τη χάραξη πορείας σε αυτό το σύνθετο και εξελισσόμενο ψηφιακό περιβάλλον», λέει ο ίδιος και προσθέτει:

«Εξοπλιζόμαστε με τελευταίας τεχνολογίας λογισμικά που υποβοηθούν στον εντοπισμό των deepfakes και αξίζει να σημειωθεί ότι, μέσω του συντονιστικού οργάνου στρατηγικής και αξιοποίησης χρηματοδοτικών πηγών της ΕΛ.ΑΣ., συμμετέχουμε ήδη σε καινοτόμα ευρωπαϊκά προγράμματα, σε συνεργασία με την ακαδημαϊκή κοινότητα και με ερευνητικά κέντρα ευρωπαϊκού, αλλά και διεθνούς βεληνεκούς, για την ανάπτυξη εφαρμογών και εγκληματολογικών εργαλείων αιχμής για τον καλύτερο χειρισμό τέτοιου υλικού».

Ο ίδιος δεν παραλείπει να τονίσει πως η χρήση της Τεχνητής Νοημοσύνης βοηθά αυτή τη στιγμή τα μέγιστα τη δουλειά των εξεταστών ψηφιακών πειστηρίων στη ΔΕΕ, ειδικά όταν απαιτείται η ανάλυση εκατοντάδων εγγράφων ή εικόνων. Από την άλλη, βοηθά και τους εγκληματίες. Οπως το θέτει ο κ. Βασιλαράς: «Πρέπει πια να εκπαιδεύσουμε μοντέλα που θα “κυνηγούν” αυτά τα έξυπνα μοντέλα. H ΑΙ θα κυνηγάει την AI. Σε κάθε περίπτωση, ο κόσμος θα πρέπει να ξέρει τι έρχεται».